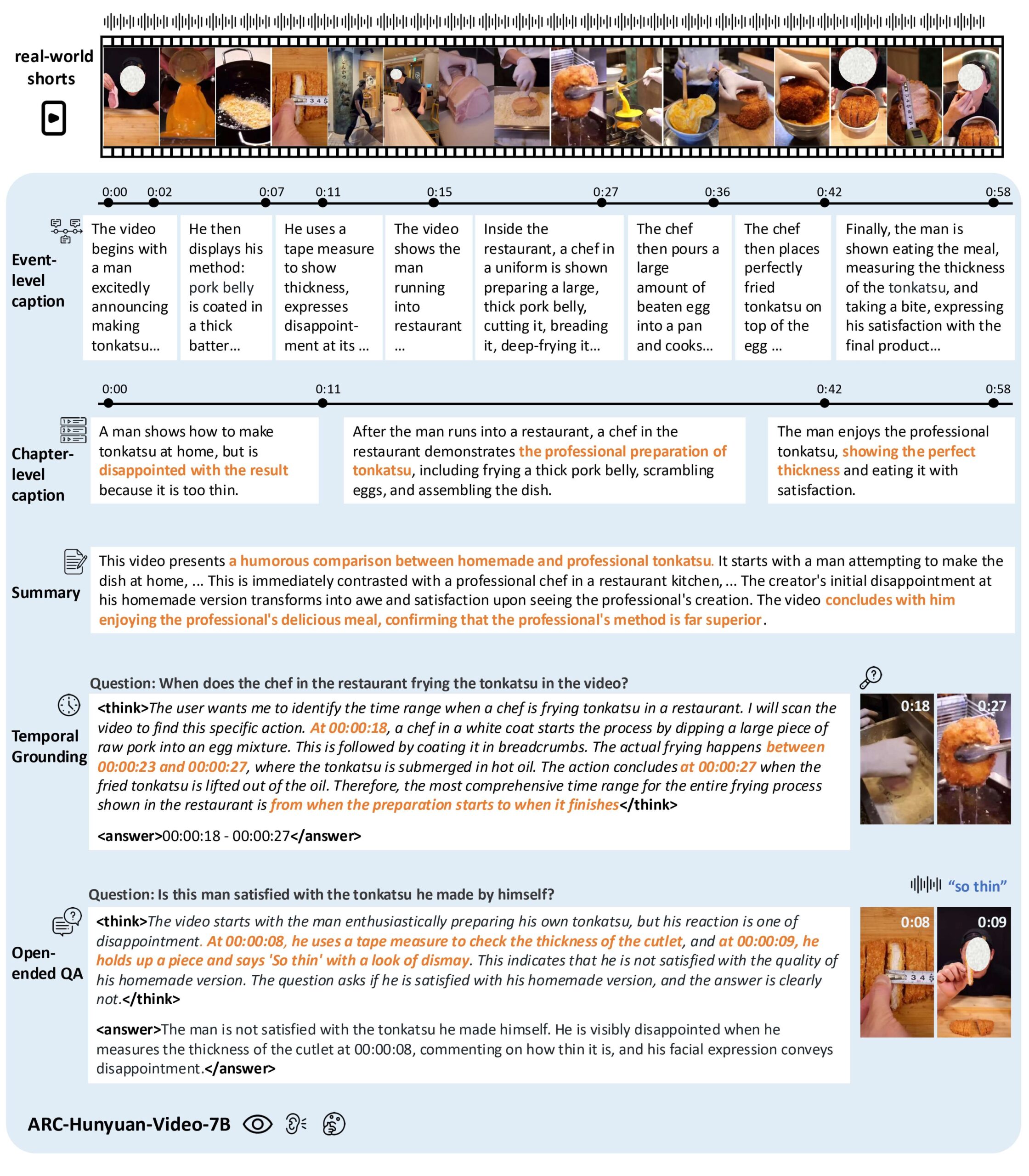

ARC-Hunyuan-Video-7B

综合介绍

ARC-Hunyuan-Video-7B 是一个由腾讯开发并开源的强大的多模态模型,专门用于深入理解真实的短视频内容。在当今这个由微信视频号和抖音等平台主导的时代,用户原创的短视频内容变得越来越普遍。这类视频通常包含复杂的视觉元素、密集的音频信息和快节奏的叙事,旨在快速传达情感和观点。传统的视频模型在处理这类内容时往往力不从心。ARC-Hunyuan-Video-7B通过端到端地处理视觉、音频和文本三种信号,实现了对视频内容的深度结构化理解。它不仅仅停留在描述视频画面的层面,而是能够深入分析创作者的意图、情感表达和核心信息。通过在真实世界的部署测试,该模型显著提升了视频检索的点击率和用户的观看时长,证明了其在实际应用中的价值。

功能列表

- 深度理解真实世界的短视频: ARC-Hunyuan-Video-7B 能够精准分析来自微信视频号、抖音等平台的用户生成内容,深入理解创作者的意图、情感和核心信息。

- 同步音视频推理: 模型能够同步处理原始的视频和音频信号,从而解答仅靠单一模态无法解决的复杂问题,例如理解小品中的幽默或产品评测中的细节。

- 精准的时间感知: 模型不仅知道视频中发生了什么,还能准确地知道事件发生的时间点。它支持多粒度的时间戳字幕、时序视频定位和详细的事件摘要。

- 高级推理和应用通用性: 经过多阶段的强化学习训练,模型展现出强大的推理能力。它支持零样本或少样本的微调,可以轻松适应各种下游应用,如视频标签、推荐和检索。

- 开源: 模型权重和推理代码完全开源,开发者可以免费使用,并在此基础上进行二次开发。

使用帮助

安装流程

在开始使用 ARC-Hunyuan-Video-7B 之前,你需要先配置好运行环境。模型的推理过程可以在单张 NVIDIA A100 40GB GPU 上完成。如果使用 vLLM 进行部署,官方推荐使用两张 NVIDIA A100 40GB GPU。

1. 克隆仓库并安装依赖

首先,从 GitHub 上克隆项目的代码仓库,并进入项目目录。

git clone https://github.com/TencentARC/ARC-Hunyuan-Video-7B.git

cd ARC-Hunyuan-Video-7B```

**2. 安装 PyTorch**

模型需要特定版本的 PyTorch,你可以使用以下命令进行安装:

```bash

pip install torch==2.6.0 torchvision==0.21.0 torchaudio==2.6.0 --index-url https://download.pytorch.org/whl/cu124

3. 安装其他依赖

接着,安装 requirements.txt 文件中列出的所有依赖包。

pip install -r requirements.txt

pip install git+https://github.com/liyz15/transformers.git@arc_hunyuan_video

4. 安装 flash-attention

为了提升模型的运行效率,建议安装 flash-attention。请根据你的 Python 版本选择合适的安装包。如果安装失败,你也可以在 video_inference.py 文件中将 attn_implementation 参数修改为 "sdpa"。

pip install https://github.com/Dao-AILab/flash-attention/releases/download/v2.7.4.post1/flash_attn-2.7.4.post1+cu12torch2.6cxx11abiFALSE-cp311-cp311-linux_x86_64.whl

5. (可选) 安装 vLLM

如果你希望使用 vLLM 加速推理,可以按照以下步骤进行安装:

git submodule update --init --recursive

cd model_vllm/vllm/

export SETUPTOOLS_SCM_PRETEND_VERSION="0.8.5"

wget https://wheels.vllm.ai/ed2462030f2ccc84be13d8bb2c7476c84930fb71/vllm-1.0.0.dev-cp38-abi3-manylinux1_x86_64.whl

export VLLM_PRECOMPILED_WHEEL_LOCATION=$(pwd)/vllm-1.0.0.dev-cp38-abi3-manylinux1_x86_64.whl

pip install --editable .

pip install https://github.com/Dao-AILab/flash-attention/releases/download/v2.7.4.post1/flash_attn-2.7.4.post1+cu12torch2.6cxx11abiFALSE-cp311-cp311-linux_x86_64.whl

模型权重

你需要下载 ARC-Hunyuan-Video-7B 的模型权重,其中包括 ViT、LLM 和原始的 whisper-large-v3。

如何使用

模型目前最擅长处理 5 分钟以内的短视频。如果你的视频超过 5 分钟,建议将视频分割成多个片段进行推理,然后使用一个大语言模型(LLM)来整合结果。

不使用 vLLM 进行推理

进入项目根目录,然后运行以下命令:

cd ARC-Hunyuan-Video-7B

python3 video_inference.py

使用 vLLM 进行推理

同样,在项目根目录下运行:

cd ARC-Hunyuan-Video-7B

python3 video_inference_vllm.py

应用场景

- 视频内容分析对视频平台上的海量内容进行自动化的分析和打标,提取视频的关键信息、情感倾向和主题,为内容推荐和审核提供数据支持。

- 智能视频检索用户可以通过自然语言描述来搜索视频内容,例如“查找关于制作红烧肉的教程”,模型能够准确地定位到相关的视频片段。

- 视频摘要和精彩集锦生成自动为长视频生成简短的摘要或精彩集锦,方便用户快速了解视频内容,提升视频的吸引力。

- 视频问答用户可以针对视频内容提出开放式问题,模型能够根据视频的画面和声音信息给出精准的回答。

QA

- ARC-Hunyuan-Video-7B 和其他视频模型有什么不同?ARC-Hunyuan-Video-7B 最大的不同在于它对“真实世界”短视频的深度理解能力。它不仅仅是简单地描述画面,而是能够结合音频和文本信息,理解视频的叙事结构、情感表达和创作者的意图,并且能够精确到时间戳。

- 我可以在自己的电脑上运行这个模型吗?可以,但你需要一块性能较好的 GPU。官方推荐至少使用 NVIDIA A100 40GB GPU。如果你只是想体验模型的功能,可以考虑使用官方提供的 API 服务。

- 这个模型支持中文吗?是的,模型支持中英文视频,并且在处理中文视频方面表现尤为出色。